3.3. Aproximacions conceptuals

3.3.6. Biaixos

El darrer bloc crític de continguts orbita al voltant dels biaixos i, per tant, posa el focus en les desigualtats causades o agreujades per les tecnologies i les seves interfícies. Això té implicacions reals i greus, com la detenció errònia d’un home negre que havia estat reconegut per una intel·ligència artificial com la persona que havia robat cinc rellotges. El que és més interessant és que la tecnologia en general i els algorismes, o les interfícies en particular, reflecteixen els biaixos de les persones que els han construït. Com a creadors, hem de parar especial atenció als nostres propis biaixos, ja que tenen conseqüències directes sobre altres persones. Consulteu la fitxa el biaix del dissenyador al Design Toolkit de la UOC.

Artísticament, podem parlar d’Estampa, un col·lectiu que aborda les escletxes dels diferents algoritmes de reconeixement facial, corporal o d’altres tipus. Els seus treballs solen tenir un caràcter de recerca que es concreta en múltiples formats (vídeo, accions o instal·lacions…) i posen, per exemple, el focus en l’ambigüitat de les diferents etiquetes que estableixen els algoritmes o en el processament d’imatges mitjançant xarxes neuronals.

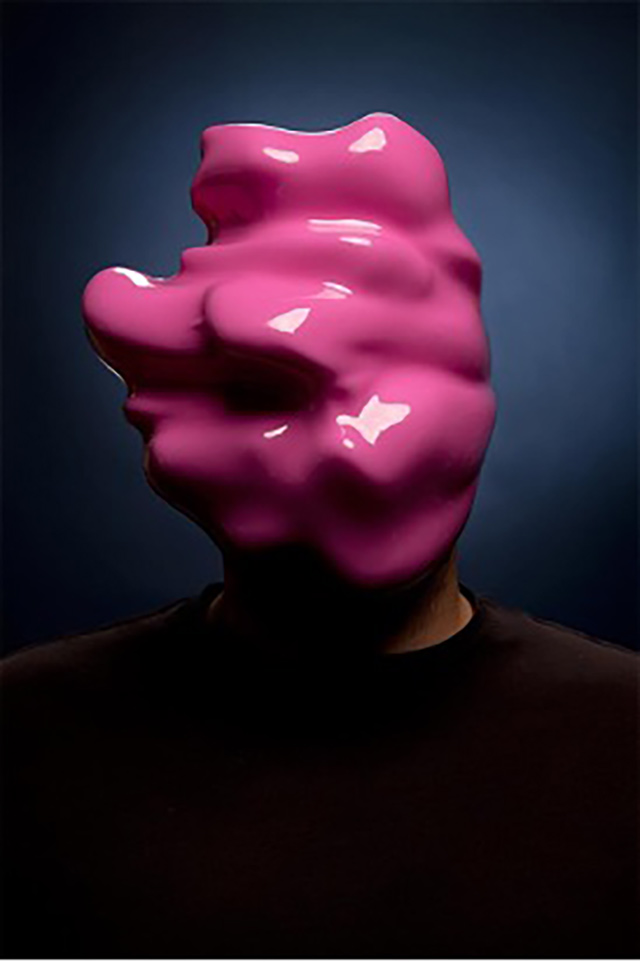

De manera més específica, podem parlar de l’artista Zach Blas i Facial Weaponization Suite, un projecte que protesta contra el reconeixement facial biomètric i les desigualtats que aquestes tecnologies propaguen. Ho fa amb tallers que consisteixen a crear màscares de forma col·lectiva, màscares que reuneixen les dades facials de les diverses persones que hi participen i que acaben tenint un aspecte amorf que no pot ser detectat com a rostre humà per les tecnologies de reconeixement facial.

Font: extret del web de l’artista.

Més concretament, també cal mencionar Fairly Intelligent, un projecte d’A. M. Darke. L’artista ha creat un algoritme especulatiu que confronta els biaixos racistes, classistes i d’altres tipus mitjançant un joc en format web al llarg del qual l’usuari respon a diverses preguntes.

Seguint les propostes en format web, Suspicious behavior, del col·lectiu Kairus (Linda Kronman i Andreas Zingerle) convida a reflexionar l’usuari sobre els prejudicis humans que acaben sent traspassats a les màquines i que influeixen, per tant, en els diferents algoritmes de reconeixement. Mitjançant un vídeo tutorial, sotmeten l’usuari a diferents proves de reconeixement d’imatges captades per càmeres de videovigilància.

Aquest projecte està directament lligat al concepte de treball fantasma (o ghost work), un terme que fa referència a les microtasques que duen a terme milions de persones per alimentar, classificar, corregir o avaluar dades. Aquestes tasques serveixen per optimitzar, per exemple, que Alexa falli menys a l’hora de reconèixer veus o que les xarxes socials detectin cossos nus . La part negativa és que aquestes feines es basen en la precarietat laboral i són invisibilitzades, fet que impedeix poder reclamar condicions de treball més justes o, fins i tot, comptar quantes persones estan dedicant el temps a aquestes tasques.